第二段開始介紹這個問題,過去如何去解決的。

The typical use of convolutional networks is on classification tasks, where the output to an image is a single class label.

說明了convolutional networks 可以解決單標籤的任務。

這邊指的應該是影像分割。

However, in many visual tasks, especially in biomedical image processing, the desired output should include localization, i.e., a class label is supposed to be assigned to each pixel.

這個樣的分類任務需要以pixel為單位 label。

可能要說明這件事情很困難。

Moreover, thousands of training images are usually beyond reach in biomedical tasks.

不對喔,上面是單純的描述。

這句說明了樣本數不夠的問題。

Hence, Ciresan et al. [1] trained a network in a sliding-window setup to predict the class label of each pixel by providing a local region (patch) around that pixel as input.

所以,在過去Ciresan et al. 使用了 "sliding-window" 去預測。

sliding-window 與 convolution network 很像,我猜差別在於window 是否是根據CNN方法訓練。

First, this network can localize. Secondly, the training data in terms of patches is much larger than the number of training images.

再看下去發現,sliding-window 只有標示位置而已,但是因為有sliding-window的關係,所以訓練的次數遠大於圖片的數量。

這樣可能會造成overfitting。

The resulting network won the EM segmentation challenge at ISBI 2012 by a large margin.

這個network雖然有缺點,但是也是有贏得比賽的。

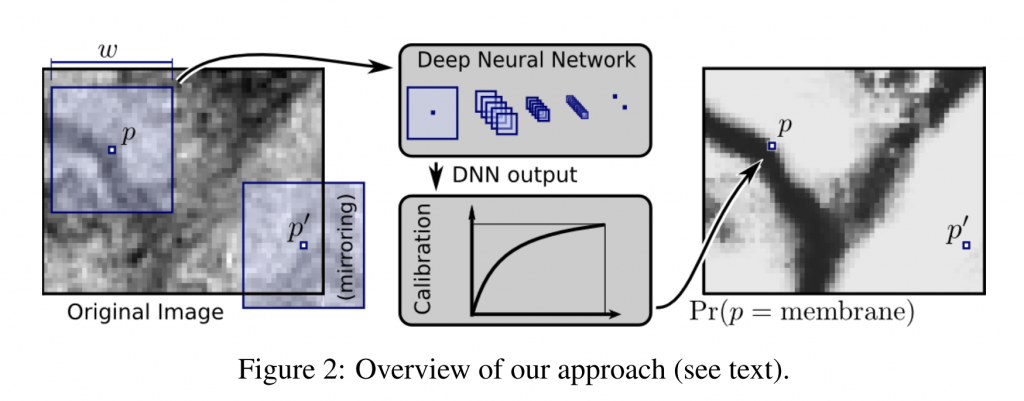

[2] Deep Neural Networks Segment Neuronal Membranes in Electron Microscopy Images

這篇文章可以看的出來是使用DNN去做影像分割,windows的部分的邏輯偏向每一個pixel的分類與附近的pixel是有相關的(已經有部分 convolution layer的概念了),可以參考一下的圖,

摘自 [2] 中的圖

但這種方法需要的訓練量實在太大了,如果一個window大是5X5,那運算的pixel數就會變成25倍數,但是這種方法卻是當時最好的方法,因為有考量到附近的像素而且可以解決訓練量少的問題。

從這一段的介紹,其實可以一窺在CNN還沒有興起時候的技術。

[1]Unet 原文

[2]Deep Neural Networks Segment Neuronal Membranes in Electron Microscopy Images